实验1:热身运动

学习要求:

- 熟悉在“雨课堂”里提交作业

- 熟悉 Typora 和 Markdown 写作

截止时间:9月25日(星期四) 22:00

大家务必注意时间,超出时间要扣分!

1、实验说明

实验报告推荐采用 Typora 软件编写,完成以后可以直接导出为PDF,也方便直接粘帖在 CSDN 等博客发布。实验报告模板如下:

<center>姓名:XXXX 学号:XXXX</center>

| 姓名和学号? | XXXX,200023230 |

| -------------------- | -------------------------------- |

| 本实验属于哪门课程? | 中国海洋大学25秋《软件工程原理与实践》 |

| 实验名称? | 实验1:热身运动 |

## 一、实验内容

XXXXXXXXXX

## 二、问题总结与体会

描述实验过程中所遇到的问题,以及是如何解决的。有哪些收获和体会,对于课程的安排有哪些建议。2、实验要求

课程项目要求做一个和智能相关的系统,需要学习一些人工智能的背景知识。看雨课堂发布的三个视频“人工智能发展史”,“ChatGPT走向通用AI之路”,“大模型时代下的人工智能”。

提交一个PDF文档,第一部分为自我介绍,内容包括但不限于以下内容:

- 介绍你自己。 比如你的兴趣爱好,你认为值得向别人展示的记忆,可以展示照片丰富网页。

- 介绍家乡,并向大家推荐食堂最好吃的一道菜。 家乡是哪儿?有什么风景名胜?有什么美食?自己最喜欢食堂的一道菜是?

- 介绍自己的成就、成果,技能和专业相关经验经历,并进行自我评估。 目前你已经具备了哪些专业知识和能力;你对哪类技术方向有兴趣;你觉得自己还缺少什么样的能力。

- 规划自己未来三年的发展设想。 考研?保研?工作?考公?你可以谈一谈自己未来三年的目标,并给出理由,也可以再细致一点具体到每一年你的规划。

- 对于课程安排的建议。 课程项目难度如何?有什么预期和建议?

第二部分,回答下面问题:

- 人工智能第二次、第三次兴起的原因分别是什么?

- “涌现能力”指的是?

- 利用CV领域的大模型对气象进行预测是可行的吗?为什么?

提交截止时间:9月25日(星期四) 22:00 。大家务必注意时间,超出时间要扣分!

3、评分规则

本次实验满分10分,按时提交并且内容符合要求8分,使用 markdown 加1分,内容质量高加1分。错过时间提交,扣1分。

4、附阅读材料

(一)人工智能发展史

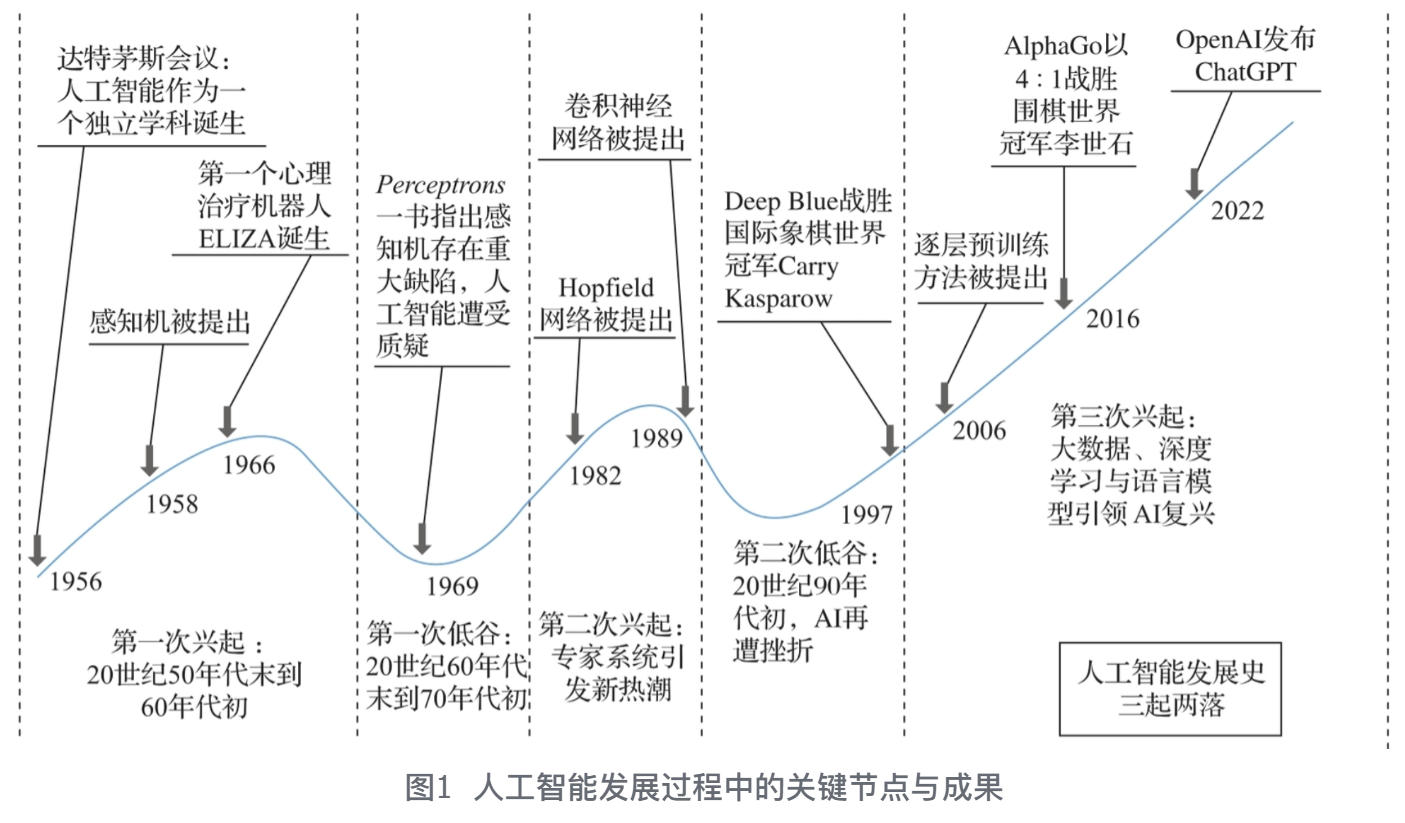

人工智能的发展之路并非一帆风顺,而是经历了跌宕起伏的“三起两落”。这段发展历程既充满激情与希望,又不乏挫折与反思。图1展示了人工智能发展过程中的关键节点与成果。

1.1 第一次兴起:20世纪50年代末到60年代初

1950年,英国数学家艾伦·图灵在他的论文——《计算机器与智能》(Computing Machinery and Intelligence)中首次提出了人工智能的概念,并给出了著名的图灵测试,书中探讨了“机器能思考吗?”这一问题。这篇论文不仅为人工智能奠定了理论基础,还为他赢得了“人工智能之父”的称号。1956年,人工智能夏季研讨会在美国达特茅斯学院召开,约翰·麦卡锡、马文·明斯基、克劳德·艾尔伍德·香农、纳撒尼尔·罗切斯特等人在会议上正式提出了“人工智能”这一术语。这也标志着人工智能作为一个独立学科诞生。图2所示为当时部分与会代表在达特茅斯大厅前的合影。紧接着,1958年,康奈尔大学的心理学教授Rosenblatt在一台IBM-704计算机上模拟实现了名为“感知机”(Perceptron)的神经网络模型,这是第一个可以自动学习权重的神经元模型。感知机的成功激发了人们对人工智能的广泛兴趣,许多研究人员和机构开始投入到这一领域的研究。

1.2 第一次低谷:20世纪60年代末到70年代初

计算能力的限制使得被寄予厚望的AI显得“笨拙”起来。1973年,法国著名数学家 Lighthill 向英国政府提交了一份报告,严厉批评了当时的AI研究,认为其未能实现预期目标。这份报告被称为“莱特希尔报告”,它直接导致了英国政府进一步大幅削减AI研究经费,其他国家也纷纷开始效仿,这对AI研究产生了深远的影响。不仅如此,在技术上,人工智能的发展也严重碰壁。1969年,“符号主义”代表人物、图灵奖获得者马文·明斯基在著作 Perceptrons: an introduction tocomputational geometry 中指出了感知机无法解决非线性可分问题的缺陷。这使得许多研究人员开始质疑神经网络的有效性,导致他们对这一领域的研究兴趣大幅下降。因此,在经济因素与技术因素的双重影响下,一场人工智能寒冬悄然降临。

1.3 第二次兴起:专家系统引发新热潮

引发此次AI复兴热潮的关键是专家系统的商用化。专家系统是一种基于知识库和推理机的计算机系统,能够模拟人类专家的决策过程。早期的专家系统是基于规则的,这种系统通过预先定义的规则来进行推理和决策。1982年,美国物理学家Hopfield发明了Hopfield网络。它是一种单层、全连接的反馈神经网络,用于联想记忆。该网络对理解复杂系统和作为深度学习早期基础有重要贡献。1983年,Hinton与Sejnowski一起发明了玻尔兹曼机(Boltzmann Machine),也被称为随机Hopfield网络。这是第一个能够学习不属于输入或输出的神经元内部表征的神经网络。它的本质是一种无监督模型,用于对输入数据进行重构以提取数据特征进行预测分析。在此期间,Paul Werbos于1974年在他的博士论文中首次提出了Beyond Regression,也就是反向传播 BP 算法。但在当时BP算法并未引起广泛的关注,真正让BP算法家喻户晓的是1986年由Rumelhart和Hinton共同在Nature上发表的论文 “Learningrepresentations by back-propagating errors”,它不仅展示了BP算法的原理,还证明了其在多层神经网络中的强大能力,为多层神经网络的学习训练提供了切实可行的方法,极大地推动了神经网络的研究。此外,1993年,BP算法夺得了国际模式识别竞赛冠军,进一步证明了它的有效性。而且,多层感知器(Multi-Layer Perceptron,MLP)与BP算法的结合,有效解决了单层感知机不能做非线性分类的问题,开启了神经网络研究的新一轮高潮。1989年,Yann LeCun 和 Yoshua Bengio 等人提出了一个卷积神经网络(Convolutional Neural Network,CNN),即著名的LeNet-5,并使用BP算法完成网络训练,成功应用于美国邮局的手写字符识别系统中。

1.4 第二次低谷:20世纪90年代初,AI再遭挫折

支持向量机(Support Vector Machine,SVM)和决策树(Decision Tree)等传统机器学习算法在这一时期大放异彩,逐渐取代了神经网络在许多应用中的地位。此外,尽管计算能力有所提升,但仍不足以支持大规模神经网络的训练和应用,这也进一步加速了寒冬的到来。

1.5 第三次兴起:大数据、深度学习和语言模型引领AI复兴

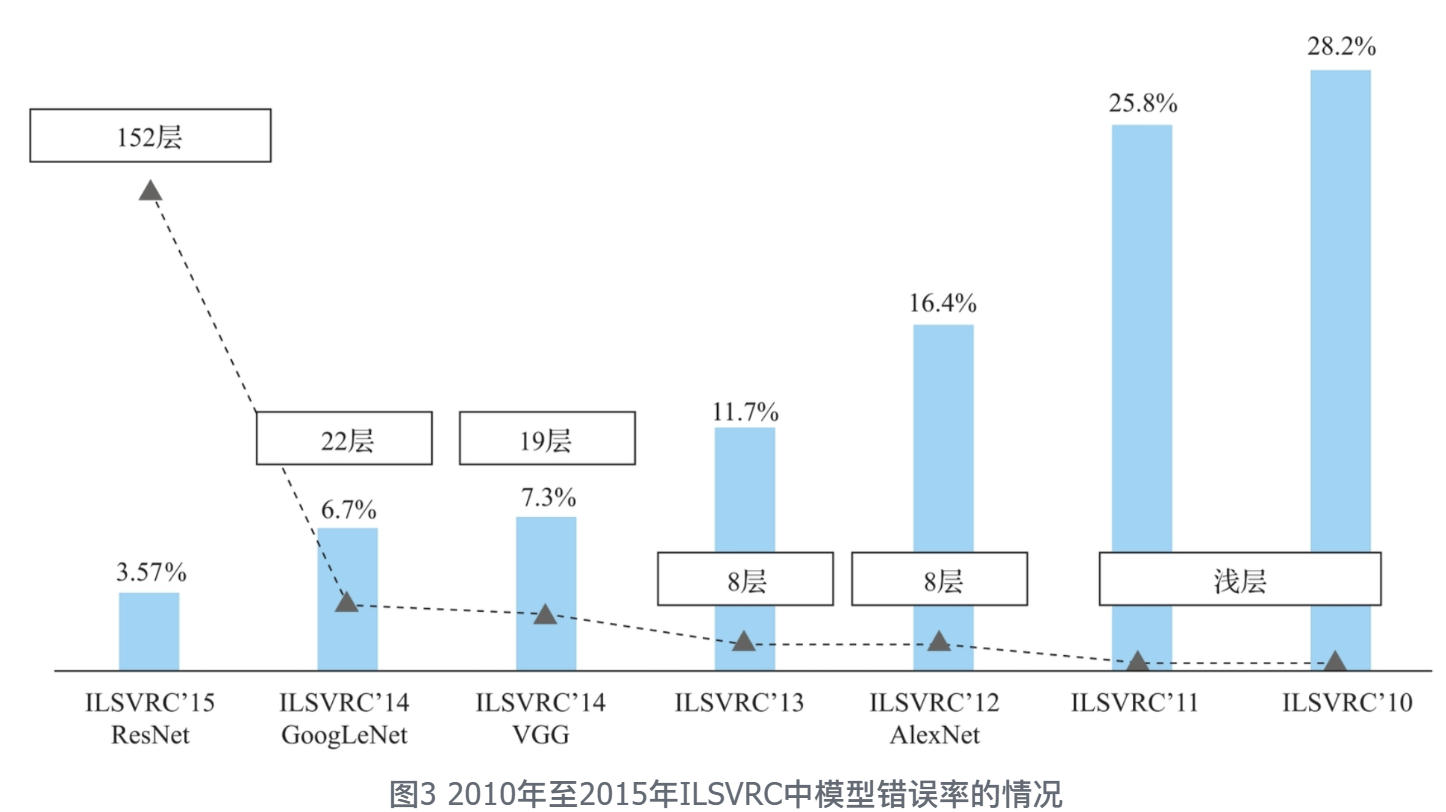

得益于算法、数据和算力三大核心驱动力的共同作用,AI开始复兴。2006年,Hinton 提出了逐层预训练的方法,为训练深度神经网络提供了有效的解决方案,成为深度学习发展的重要里程碑。具体来说,在传统的随机初始化方法中,深层网络的梯度往往在反向传播过程中变得极小,导致底层参数几乎无法更新,即所谓的梯度消失问题。逐层预训练为每一层提供了一个更优的初始状态,使得整个网络的训练变得可行,有效缓解了深层神经网络训练中的梯度消失问题。与此同时,GPU为算法提供了强大的硬件支持。GPU原本是为了让游戏玩家体验更逼真的画面而生,却意外成为AI发展的“救命稻草”。GPU相比于CPU拥有更多独立的大吞吐量计算通道,适合计算密集和数据并行的程序。从2016年的NVIDIA GTX 1080到2020年的A100,仅仅在4年时间里,GPU的性能就提升了约3倍。这种性能的飞跃使得研究人员能够:①训练更大规模的模型,例如,从最初的AlexNet(约6000万个参数)发展到GPT-3(约1750亿个参数);②使用更大的数据集,从最初的ImageNet(约1400万张图片)到可以处理数十亿规模的数据集;③更快的迭代实验,加速了模型优化和创新的过程。这种算力的提升不仅加快了深度学习的发展速度,还使得一些在过去被认为不可能完成的任务变为现实。 ImageNet数据集由美国斯坦福大学的李飞飞教授等人于2009年创建发布的,包含了超1400万幅图片,涵盖了2万多个类别,可用于支撑图像分类、定位、检测等方向的研究。加之前面提到的强大的算力支撑,使得人工智能技术能够在这片数据海洋中自如遨游,不断学习和进化。这里不得不提到深度学习技术蓬勃发展的直接见证者——ImageNet竞赛ILSVRC,其全称为ImageNet Large Scale Visual Recognition Challenge。起初,统计机器学习算法在比赛的前两届中拔得头筹,最低Top-5分类错误率达到了25.8%,如图3所示。2012年,Hinton 和他的学生 Alex Krizhevsky 设计的AlexNet横空出世,在ImageNet竞赛上大获全胜,将最低Top-5分类错误率降低至16.4%,相比于2011年的冠军方案性能提高约10%。这是历史上第一次有模型在ImageNet数据集获得如此出色的表现,引爆了神经网络的研究热情。AlexNet包含5个卷积层和3个全连接层,总计约6000万个参数,这在当时可以说是非常深的网络架构了。这种网络架构为之后的深度卷积神经网络的设计提供了重要的指导。创新的网络架构再加上现代GPU的加持,使得AlexNet就像一位借助外骨骼装甲的超级英雄,以压倒性的优势击败了所有对手,在深度学习历史上留下了浓墨重彩的一笔。

2015年,微软亚洲研究院的何凯明等人凭借深度残差网络(Deep Residual Network,ResNet)的突破性创新,在ImageNet竞赛中大放异彩,赢得了图像分类和物体识别任务的双料冠军。此外,谷歌在这一时期开源了TensorFlow框架,采用Python语言编写,并支持多种深度学习算法。同年12月,埃隆·马斯克等人在美国旧金山共同创立非营利性研究机构OpenAI,该公司怀揣着确保通用人工智能(即一种能够高度自主并在广泛经济活动中超越人类能力的系统)惠及全人类的崇高愿景,开始踏上了探索之旅。

2016年,谷歌提出了联邦学习(Federated Learning)的概念,它巧妙地解决了数据隐私与分布式学习之间的难题,允许算法在多个持有本地数据的边缘设备或服务器上独立训练,而无须直接交换数据样本。同年,AlphaGo在围棋界掀起了惊涛骇浪,它以4:1的战绩击败了围棋世界冠军、职业九段棋手李世石,在全球范围内引发了关于人工智能潜力与未来的热烈讨论。

2020年,谷歌DeepMind团队的AlphaFold2 人工智能系统在蛋白质结构预测领域实现了重大突破,它犹如一座里程碑,标志着该领域迈入了一个全新的时代。在万众瞩目的国际蛋白质结构预测竞赛中,AlphaFold2以卓越的表现脱颖而出,精准地预测了蛋白质的三维结构,其精确度之高,几乎可与冷冻电子显微镜、核磁共振及X射线晶体学等尖端实验技术相抗衡,展现了人工智能在生命科学领域的非凡实力。

2021年,OpenAI引领了另一场技术革命,推出了两款颠覆性的神经网络模型——DALL-E 与CLIP。DALL-E以其独特的创造力,能够根据文字描述直接生成生动逼真的图像,实现了文字与视觉艺术的无缝融合;而CLIP则展现了强大的跨模态理解能力,能够精准匹配图像与对应的文本类别,进一步拓宽了人工智能在内容理解与生成方面的应用边界。

2022年,ChatGPT(Chat Generative Pre-trained Transformer)的横空出世标志着大模型时代的来临。以ChatGPT为代表的通用大语言模型是人工智能领域的一项重大突破,它们通过海量数据的深度学习与复杂神经网络的构建,展现出了前所未有的自然语言处理能力和智能交互水平。这些大模型不仅能够进行流畅、连贯的对话,还能在多个领域提供精准的信息解答、创意生成与问题解决方案,极大地拓宽了人工智能的应用边界。

(二)大模型时代下的人工智能

大模型(Large Model)又称基础模型(Foundation Model),是指一类集成了海量参数与复杂结构的机器学习架构,它们擅长驾驭巨量数据,胜任各类复杂任务。在媒体聚光灯下频繁亮相的大语言模型(Large Language Model,LLM)便是大模型家族中璀璨的一员,它在自然语言处理、文本创作及智能对话等多个领域展现了卓越的性能,产生了广泛与深远的影响。最新研究发现,当模型参数量与训练数据集规模达到某一临界阈值后,模型在特定任务上的表现将实现质的飞跃,并自发地展现出诸多原先难以预见的复杂能力与特性。这种从海量数据中自动萃取并创造出新层次特征与模式的能力,被形象地称为“涌现能力”,它成为大模型相较于小型模型最为本质的区别与优势。

2.1 ChatGPT——走向通用性AI之路

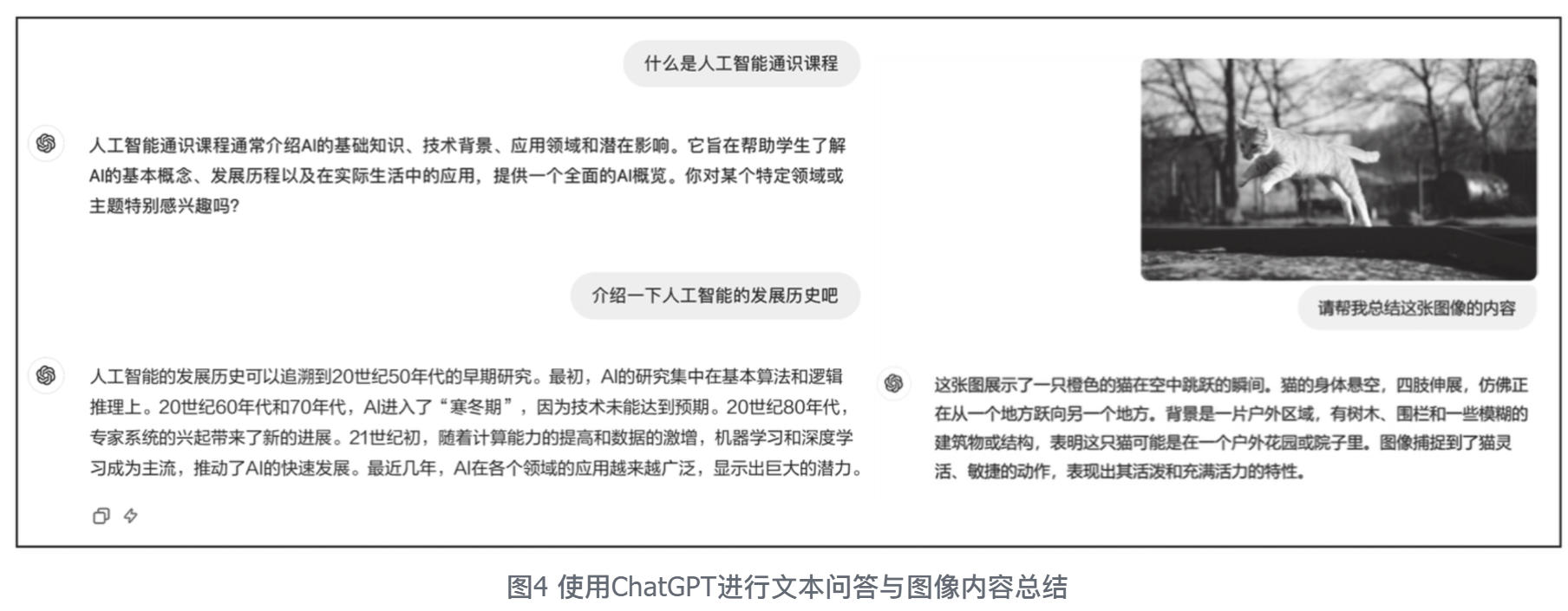

ChatGPT是由OpenAI公司研发的先进聊天机器人程序,自2022年11月30日面世以来,便以其卓越的对话能力和自然语言处理技术引起了广泛关注。ChatGPT的核心是一个名为GPT(General Pre-trained Transformer)的深度学习预训练Transformer模型,它通过在海量的文本数据上进行预训练来学习语言的语法、词汇和一定范围内的世界常识。在训练阶段,模型通过自监督学习来预测句子中的下一个词或填补句子的空白。这种训练方式使得ChatGPT能够掌握并理解语言结构,并进一步学习蕴含在文本信息中的知识。此外,最新的GPT-4中还引入了多模态功能,模型可以通过联合处理图像和文本数据进行训练,从而理解和生成与图像相关的文本描述。图4分别展示了ChatGPT在文本问答和图像理解上的能力。

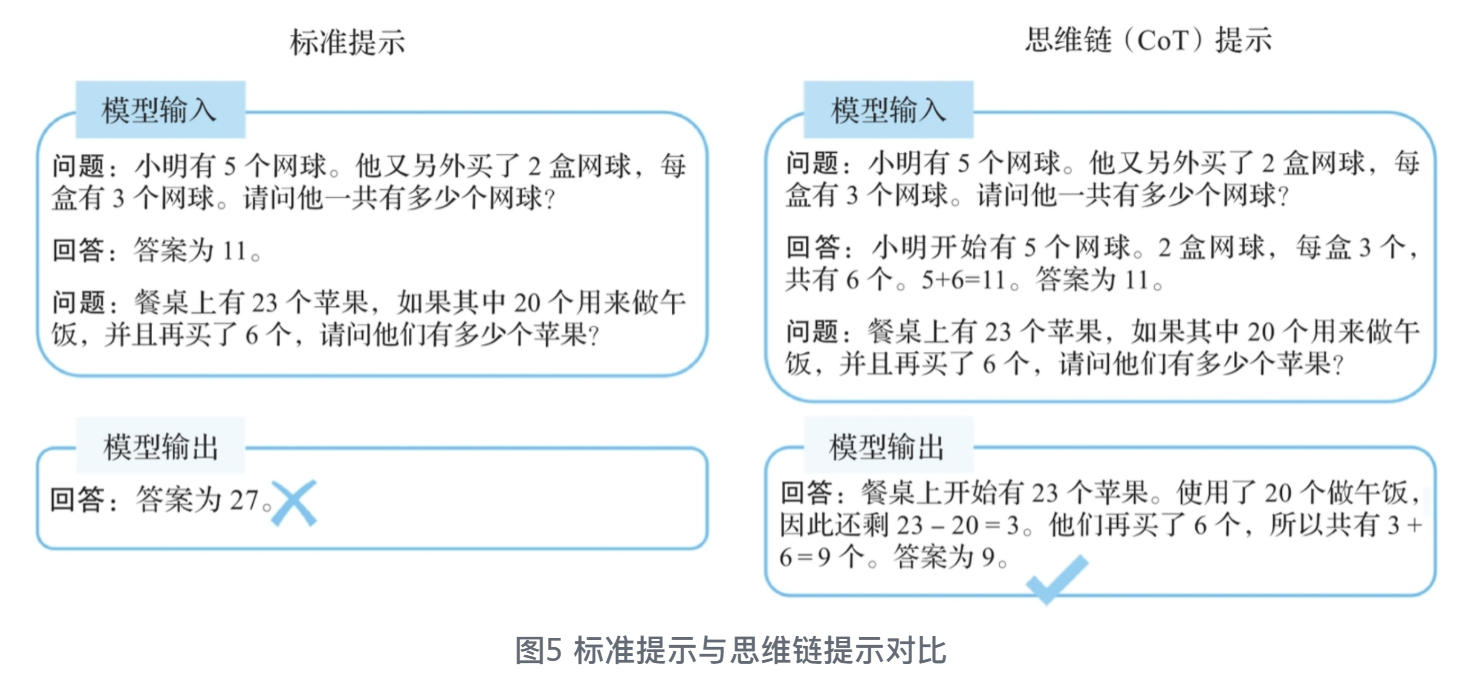

虽然ChatGPT具有强大的自然语言处理能力,但其输出质量在很大程度上取决于用户输入的提示词。通过合理的提示词设计,用户可以更好地引导模型生成连贯、准确且有用的回答。思维链(Chain of Thought,CoT)就是一种指导用户设计提示词的技术。如图5所示,这个技术通过要求模型将一个复杂问题逐步分解为一个个子问题并依次进行求解,并显式输出中间每一步的推理步骤,从而模拟人类的思考过程,生成更复杂和精确的输出。CoT大幅度提高了LLM在复杂推理任务上的表现,并且输出的中间步骤方便使用者了解模型的思考过程,提高了大模型推理的可解释性。目前,思维链推理已经成为大模型处理复杂任务的常用手段。

除了ChatGPT外,很多国产的大模型同样具有强大的性能。例如智谱AI的智谱清言模型基于GLM模型开发,具备内容创作、图像理解、信息归纳总结等能力;科大讯飞的星火大模型则在语音识别和语音合成等任务上展现出卓越的效率和优秀的表现力;百度的文心一言大模型有着出色的联网搜索能力,在文学创作、问题解答等方面表现出色;阿里的通义千问大模型有着强大的思维启发能力,能够对复杂问题进行拆解,帮助用户启发创意,辅助用户学习各种知识;月之暗面(Moonshot AI)的Kimi Chat大模型则专注于长文本处理,支持对20万汉字的长文本进行文档总结和内容拆解。

大模型等技术上的突破性成就让研究人员开始畅想通用人工智能的道路。毕竟,如果一个AI系统能够理解和生成人类语言,那么获取知识、进行推理,甚至产生创意似乎都不再是遥不可及的梦想。大模型的出现无疑开启了AI应用的新纪元,从智能写作助手到代码自动生成,从虚拟客服到个性化教育,这些大模型正在悄然改变着人们的工作和生活方式。它们就像是给每个人配备了一位能干的程序员朋友,随时准备搜集并生成信息、回答问题、提供建议,抑或只是陪你聊聊天。大模型的出现释放出了无穷的可能性,它们正在重塑人们与技术交互的方式,挑战人们对智能的理解,也迫使人们思考人类在AI时代需要扮演的角色。

2.2 百花齐放的多模态大模型

尽管大语言模型在处理文本数据方面表现出色,但它们无法直接处理图像、视频、音频等多种模态信息之间的相互作用,也无法充分理解不同模态之间的上下文关系。因此,在一些需要跨模态理解的任务中,如图像问答、视频描述等,大语言模型的表现往往不尽如人意。这催生了一个新的研究领域:多模态大模型(Large Multimodal Model,LMM)。它通过融合多种模态的信息,能够在更广泛的场景中提供更全面、更准确的理解和生成能力。这些模型通过大规模的数据训练,学习如何联合理解和生成跨多种模态的信息,被视为通往通用人工智能的下一个重要步骤。

(1)以文为引,化影成真——文生视频大模型

早期文生视频(Text to Video,T2V)模型通常采用简单的编码-解码结构在较小规模的人工标注数据上进行训练,并将文本嵌入和视频帧独立处理,缺乏对文本与视频之间复杂关系的深度理解。因此,这些模型生成的视频在视觉效果上往往较为粗糙,缺乏真实感,而且无法生成高分辨率、细节丰富的视频。此外,早期T2V模型在生成多帧视频时,帧与帧之间的过渡不自然,导致视频中的动作显得不连贯或僵硬。

2024年,OpenAI公司发布人工智能文生视频大模型Sora,它是在OpenAI的文本到图像生成模型DALL-E基础上开发而成的,能够根据用户的文本提示创建最长60s的逼真视频。Sora展现了其深度模拟真实物理世界的能力,能够生成包含多个角色和特定运动的复杂场景。Sora采用了更为先进的多模态融合架构,通过将文本和视觉信息深度结合,模型能够更好地理解文本的复杂语义,并将其准确映射到视频生成过程中,使得生成的视频能够精确反映文本描述的内容和细节。Sora还采用了更复杂的生成网络和图像增强技术,如高分辨率生成网络和超分辨率重建技术。通过多层次的生成对抗网络(Generative Adversarial Network,GAN),Sora能够生成高分辨率且细节丰富的视频,克服了早期模型在生成质量上的缺陷。此外,为了保证视频帧与帧之间的连贯性,Sora还引入了时间一致性模块,通过平滑处理相邻帧之间的过渡,确保动作和场景在时间轴上自然流畅。,对Sora模型输入这样一段文字提示:“一个时髦的女人走在东京的街道上,到处都是温暖发光的霓虹灯和城市标志。她穿着皮夹克、长裙、靴子,拿着一个钱包,戴着太阳镜,涂着口红。她走起路来自信而随意。潮湿和反光的街道创造了一个彩色灯光的镜子效果。许多行人走来走去。”Sora便会对文本描述进行深入理解并生成对应的60s的视频,图1-14展示了其中一帧的生成效果,画面的完整程度、画面质量、细腻程度都堪称完美。完整视频详见https://openai.com/index/sora/

快手研发的可灵(Kling)大模型,采用Diffusion Transformer架构,并结合3D时空联合注意力机制更好地建模了复杂时空运动,从而生成符合运动规律并具有较大幅度的视频内容,同时能够符合运动规律。得益于高效的训练基础设施、强大的推理优化和可扩展的基础架构,可灵大模型能够生成长达2min的视频,且帧率达到30fps。

**(2)AI观天训象术——盘古气象大模型 **

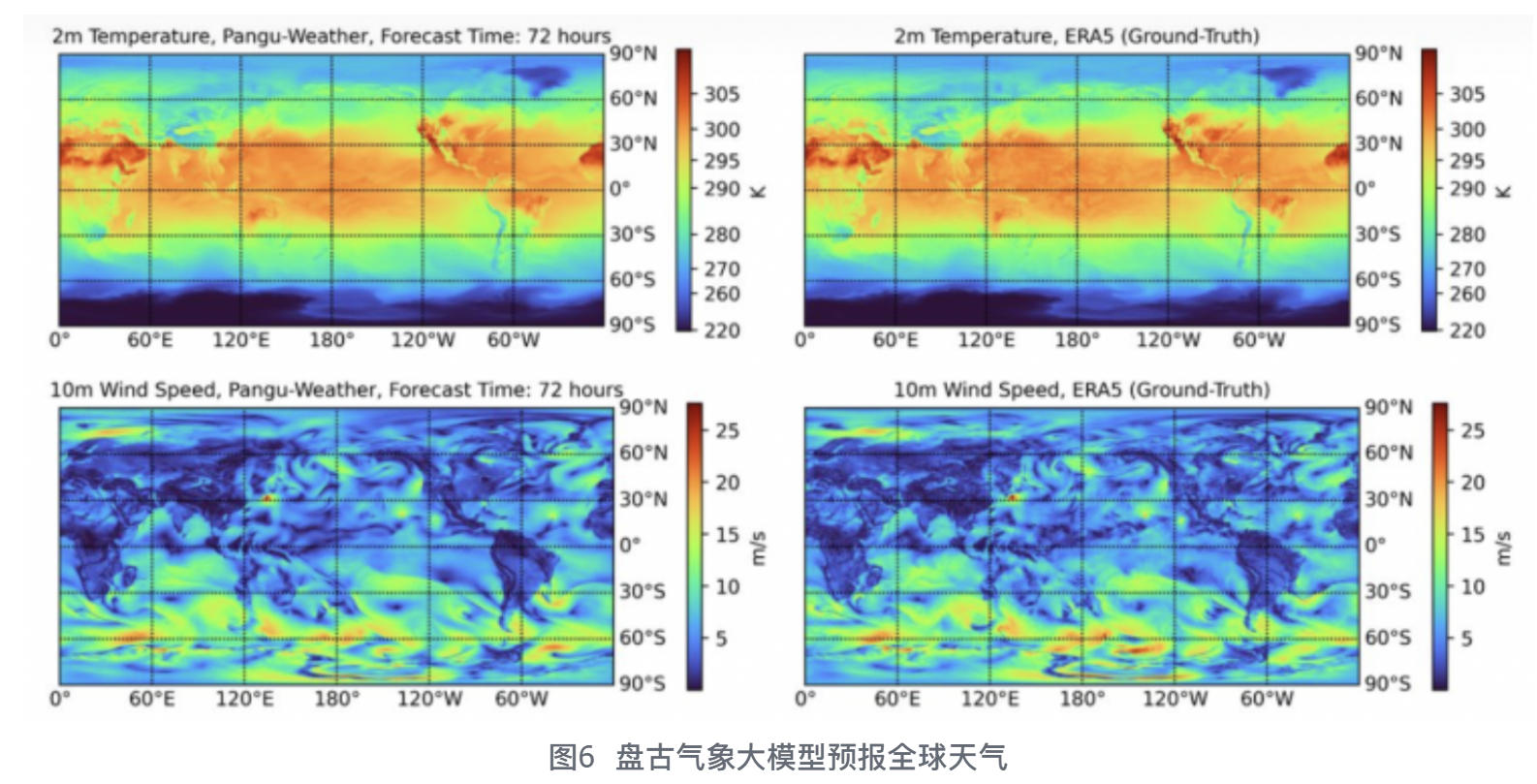

随着全球气候变化的加剧和极端天气事件的频发,提高天气预报的精度和时效性变得尤为重要。传统的数值天气预报方法虽然取得了一定的成果,但在处理复杂的气象数据和捕捉细微的气象变化方面仍存在不足。在人工智能驱动的气象科学领域,盘古气象大模型通过深度剖析海量气象数据,提供了更为精准且及时的天气预报服务,显著增强了人类应对自然灾害的预见能力。盘古气象大模型是由华为云研发的创新AI气象预报系统,是AI4Science领域的代表性技术突破。作为首个精度超过传统数值预报方法的AI模型,盘古气象大模型不仅在预测速度上实现了革命性的提升——提速高达10000倍以上,而且在预测精度上也展现出显著的优势。图1-16所示为盘古气象大模型发布会现场。

盘古气象大模型的设计思路十分明确:由于气象数据与图像数据之间存在诸多的相似之处,那能否利用当前计算机视觉(Computer Vision,CV)领域的大模型对气象数据进行分析与预测?答案是肯定的。但是直接将现有的CV大模型架构应用于气象预测还有诸多不足之处。在前人研究成果(如英伟达的FourCastNet)的基础上,盘古研究团队发现,导致CV大模型预报精度不足的主要原因有两个:①现有的气象预报模型都是基于2D神经网络的,无法很好地处理不均匀的3D气象数据;②AI方法缺少数学物理机理约束,因此在训练的迭代过程中会不断累积迭代误差。为此,盘古气象大模型设计了3D Earth-Specific Transformer(3D EST)模块来处理复杂的不均匀3D气象数据,并且使用层次化时域聚合策略来减少预报迭代次数,从而减少迭代误差,大幅提升了模型预测的准确率。该大模型仅需在一块V100显卡上运行1.4s,就能完成24h全球气象的预报,位势、湿度、风速、温度、海平面气压等复杂信息可以在一块屏幕上一目了然。

2023年10月,盘古气象大模型成功预测了飓风“奥帝斯”的实际运行路径,其预测曲线与飓风实际运行路径几乎一致,精度达到了气象预报的新高度。这一预测结果展示了盘古气象大模型在复杂气象条件下的卓越性能。盘古气象大模型的研究成果已在国际学术顶级期刊Nature上发表,获得了审稿人的高度评价:“华为云盘古气象大模型让人们重新审视气象预报模型的未来,模型的开放将推动该领域的发展。”这也是近年来中国科技公司首篇作为唯一署名单位发表的Nature正刊论文。随着盘古气象大模型的不断优化和升级,其在气象预报领域的应用前景广阔。例如,新增的降水预测功能将进一步提升预测精度,对暴雨红色预警的预测从提前3小时升级至提前24小时。此外,华为云与泰国气象局联合开发的泰国盘古气象大模型,以及与深圳市气象局合作打造的区域气象预报大模型,是盘古气象大模型在国际和地区气象服务中的重要应用实例。总之,盘古气象大模型的推出,不仅代表了华为云在AI气象预报领域的技术实力,也为全球气象预报服务带来了创新和突破,预示着未来气象预报将更加精准、高效。

(3)万物皆可分——分割大模型SAM

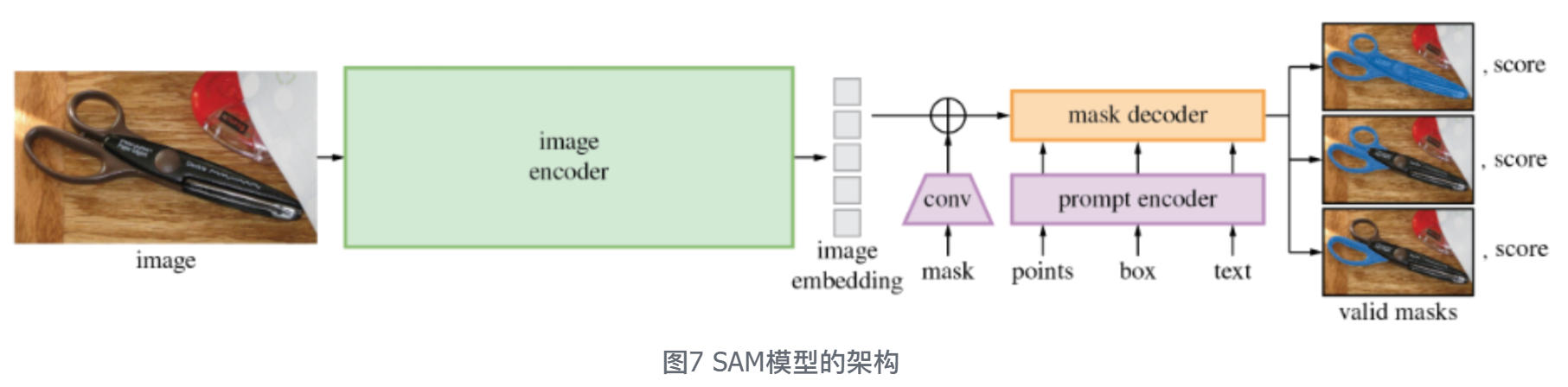

SAM(Segment Anything Model),作为Meta公司的一项里程碑式创新成果,在计算机视觉领域开创了前所未有的图像分割新纪元。设想一下,只需指尖轻点或随意勾勒几笔,计算机便能即时洞悉图像奥秘,精准分离并识别出画面中的任意目标物体——这一设想在SAM技术的加持下,已不再是遥不可及的科幻梦想。自Meta推出SAM以来,其影响力已跨越学科界限,在科学探索、医学诊断,乃至众多工业领域激发出新的活力。众多知名数据标注平台纷纷将SAM纳入其生态系统,将其作为图像对象分割标注的首选工具,这一举措节省了数百万小时的人工注释时间。SAM的应用场景广泛而深远,从海洋生态保护的珊瑚礁精细分割与声呐图像智能分析,到紧急救援中的卫星图像快速解译,从医疗领域细胞图像的精准分割,到农业中作物生长分割和病害检测,SAM以其卓越的性能正在发挥着越来越重要的作用。

尽管SAM在捕捉图像中对象目标方面展现出了优越能力,但必须认识到,图像仅是瞬息万变现实世界的静态缩影。为了更全面地捕捉动态场景的本质,Meta随后推出了SAM 2,这一创新成果在统一的框架下,实现了基于用户动态提示的图像/视频智能分割。与SAM侧重于静态图像的处理不同,SAM 2允许用户在视频的任意帧中灵活插入输入提示(如点、框或初始掩码),以此界定并预测目标对象的时空掩码。SAM 2的核心优势在于其即时响应与高效传播机制:一旦接收到用户提示,它便能迅速在当前帧上生成初始掩码,并沿时间轴扩展至整个视频序列,精准描绘出目标对象的动态轮廓。更令人瞩目的是,用户还能在视频播放过程中随时添加额外提示,对初始掩码进行迭代优化,这一过程可按需重复,直至达到用户期望的精确度。这极大地增强了交互的灵活性与结果的准确性。从架构层面看,SAM2不仅是SAM在视频领域的自然延伸,更是对图像与视频分割效率的一次革命性提升。相比SAM,SAM 2在标注速度上实现了约6倍的提升,并将所需的人机交互减少了大约3成,这极大地提升了其作为数据标注工具的效率。

尤为值得一提的是,鉴于3D图像本质上可被视为一系列连续变化的2D图像(即特殊视频),SAM 2的推出也为3D图像分割领域提供了新的解决思路,预示着其在复杂空间数据解析中的广阔应用前景。不仅如此,许多重要的工程应用也都需要在视频数据和3D数据中进行准确的对象分割,例如混合现实、机器人、医疗手术机器人、自动驾驶汽车和视频编辑等。在工业领域,如自动驾驶汽车中使用的系统,它可以为视觉数据提供更快的注释工具,以训练下一代计算机视觉系统。对于内容创作者来说,SAM 2可以在视频编辑中实现创意应用,并为生成视频模型增加可控性。图1-18生动地展示了SAM 2在视频处理中的卓越表现,进一步印证了其在动态场景理解和分析中的非凡能力。正如社交网站Facebook的创始人 扎克伯格 指出的那样,SAM与SAM 2等开源AI大模型“比任何其他现代技术都更有潜力提高人类生产力、创造力和生活质量”。

然而,大模型技术的发展也面临着诸多挑战。排在首位的便是计算资源消耗问题,训练一个通用基础大模型便要消耗数百万度电。此外,模型的偏见、幻觉等问题,以及可能被滥用以生成虚假信息等伦理问题,都是亟待解决的难题。“大模型的偏见是指模型在处理数据时表现出的某种偏好或倾向性,这种偏好可能导致模型在特定情况下做出不公平或不准确的预测。幻觉问题则是指模型在生成内容或决策时,可能会产生一些看似合理但实际上是错误或虚假的内容,这通常源于模型的过拟合或训练数据的不足。”

这一次,我们无法断然笃定地回答AI发展的持续性问题,但至少有一点是确定的:AI的发展历程告诉我们,科技的进步往往不是一帆风顺的,我们需要保持热情,同时也要脚踏实地地不断探索和创新。